年度論壇2》當AI理解感情,他也能(幫忙)處理情緒勞動嗎?

編按:在同溫層加厚、意見兩極化、人人都存有社群焦慮的時代,ChatGPT究竟會成為不斷攀升的單身人口的救贖?或是將加速無可避免的人際疏離?如今人工智慧也開始應用於諮商、醫療照護等的領域,AI能勝任或取代情緒勞動嗎?

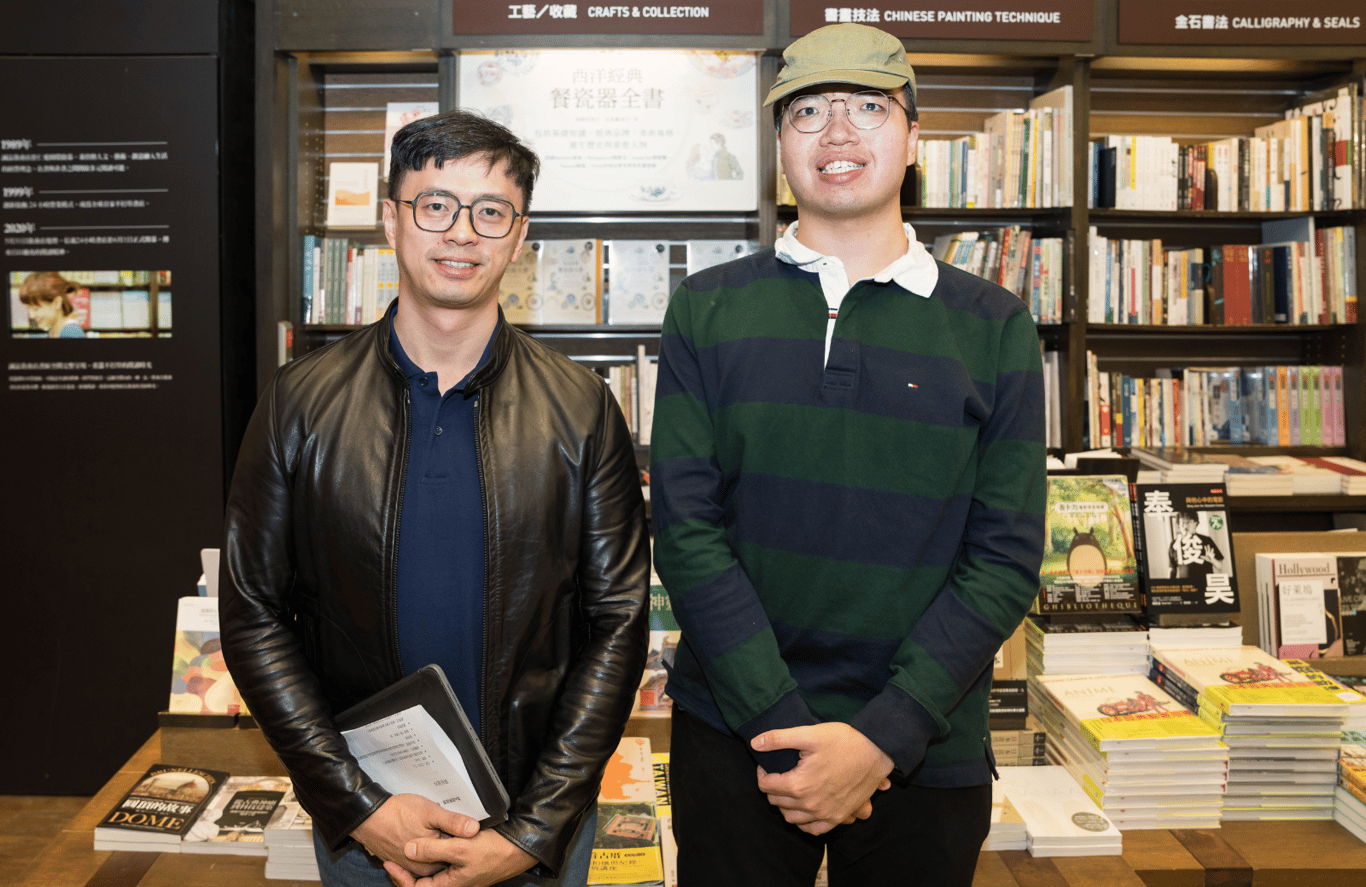

Openbook年度論壇第二場,邀請到研究專長為人工智能與社會學的東吳大學社會系副教授劉育成,以及致力於大型語言模型的中研院中文詞知識庫小組成員吳昱宏,一起探討AI如果有了情感能力,可能面臨的道德與價值觀等問題。

➤AI能勝任或取代人類的情緒勞動嗎?

在談AI有無可能分擔人類情緒之前,劉育成首先解說「情緒勞動」的定義。情緒勞動(Emotional Labor)一詞,1983年由美國學者霍奇查爾德(Arlie Hochschild)提出,主要指職場上人們透過情緒管理,面向公眾的臉部表情與肢體表現。

「簡單講,所有人都在情緒勞動,我坐在這裡,也在情緒勞動。也就是我必須壓抑或調整我的情緒表現,來符合這個場景,所以有些情緒我可以表達出來,有些不行。」反觀AI沒有情緒,使用者知道他不是面對一個「人」,所以無須對AI情緒勞動,甚至會很不客氣地對它做出「奇怪的事情」。

因此劉育成認為:「無論AI能否勝任人類情緒勞動的工作,其實某種程度它已經分擔了我們的情緒勞動,讓我們使用它時不用顧慮自己情緒是否得宜。」他說:「但它沒辦法取代『人類自己』的情緒勞動。」因為這件事的主體永遠在人身上,用在社會裡與他人相處互動。

「除非AI有情緒。這會是一件很有趣的事情——你希望ChatGPT跟你鬧脾氣或開玩笑嗎?或希望它今天用很悲傷的方式跟你講話嗎?現在AI的情感運算方式,有文字、聲音,還有臉部的幾種表情變化,我們看待這些AI演算法或機器人,到底期待它什麼?是值得我們思考的。」

吳昱宏也同意AI足以勝任部分職業上的情緒勞動,但無法完全取代。「可以勝任的主要原因,是它的客觀性及中立性。」他說:「你會發現它處理問題很難給出一些跳脫現實的回答,比如心理諮商,它會以實際的角度提供你解決方式(比如怎麼釋放壓力),而且它最大特點,是很愛用條列式去幫助你了解問題,但不太可能安撫你。」

以客服為例,代表公司回答問題,一定要保持中立,不能受個人或客戶的情緒影響,因此AI就能部分取代這些職業。吳昱宏說:「尤其大企業人力成本巨大,若有語言模型取代這些工作,就能大幅降低成本。此外客服人員需要休息,但語言模型可24小時為你服務,即時性問題就得以解決。」

但為何不能完全取代?吳昱宏表示,中立性是AI最大優點,卻也是遠大於優點的缺點。回歸問題本質,今天人們尋求心理諮商師的協助,可能更大需求是獲得鼓勵與支持,而不只是解決問題,所以當必須帶更多情感去進行這個工作時,AI就還有很長一段距離。

且吳昱宏認為,「使用ChatGPT解決困境」這個行為是個隱憂,長遠來看對人際關係有負面影響。畢竟情緒對人類溝通非常重要,過度依賴ChatGPT可能造成人際疏離。「比如在學校被欺負、在職場被老闆電,回家打開ChatGPT打打字就好,人的情感慢慢消失,會忘記人之間的社交或職場遇到的狀況該怎麼面對。」

➤如何訓練大型語言模型學習和模仿

想利用AI協助情緒性服務,需要訓練大型語言模型學習模仿人類的情感與行為。訓練分三階段,第一階段為預訓練,如同教AI講話、灌輸它基本知識,訓練資料諸如維基百科、網路文章、書籍之類內容,非常大量。

預訓練結束,模型會變成一個很會預測資料的機器,但尚未具備目前ChatGPT的任何能力。所以第二階段要教AI一些技能,此時的訓練資料是結構性問答,答案並會通過很多人的驗證。跟以量取勝的預訓練最大差別是,第二階段以品質取勝,因為AI的所有知識在第一階段就已訓練完成。

第二階段結束的AI飽讀詩書,但尚未社會化,所以第三階段要教它人類的價值觀,包括人類有哪些禁忌、哪些事情不能做、面對問題該怎麼回答。吳昱宏說:「比如問它怎麼做炸彈,第二階段結束後,它絕對會用它深奧的化學知識一五一十回答你。但一個被廣泛使用的AI不能這樣回答,所以第三階段後,我們就得到現在ChatGPT的回覆:我沒辦法幫你這件事。」

這個流程有多重要呢?吳昱宏提到ChatGPT-4發表的一篇超長論文:「在100頁中,我們關注的模型架構、大小、怎麼訓練、資料集多大等,4個加起來總共才200字,剩下99.8頁都在說自己模型有多強,此外很大部分都在講它第三階段做了什麼事。」

回到如何讓AI學會人類情感,吳昱宏表示,重點就在第三階段。除了解決一些危險問題,也非常注重訓練AI「讀懂」人類。「問題是即便讀懂人類情感,但怎麼回覆,目前ChatGPT做得並不好,原因是這方面資料不夠多,導致它無法處理比較複雜的人類情緒、無法針對隱含的情緒給予好的應對。」他說,很多情緒勞動工作是非常專業的(例如心理治療師),所以目前還沒有什麼辦法可以驗證AI情緒勞動的合理性和有效性。

吳昱宏分享:「現在最主流的方式,是請專家判別。」例如拉出10萬筆這類回覆,請100個專家在模型與基準模型之間進行評分,只要這個模型獲選比例較高,就間接證明它相對較好。「另一個解方是換ChatGPT來評。」就一直問它哪個回覆比較好,最後統計出來,直接放在論文上。雖然聽起來有點荒謬,但現在學界都這樣做,是目前一大趨勢。

➤AI的精準翻譯,可以解決文化跟情感上的距離嗎?

科技趨勢專家Kevin Kelly在《5000天後的世界》預測,隨著人工智慧的進展,未來精準翻譯可讓各種語言即時交流,勞動市場就能跨越文化和地域限制,大家一起共事。如此可以解決文化跟情感上的距離嗎?AI的應用究竟會加深還是縮短階級的差距呢?

對此,劉育成認為AI跨語言的翻譯,確實可以有效打破人跟人、國與國、族群和族群的語言隔閡,當人們知道彼此在想什麼,當然可以縮短文化的距離。「但我覺得真的要能夠完全解決,還是一個問號。」因為不論是否使用共通語言,也不管怎麼努力,人跟人之間多少還是存在文化跟情感距離。他說:「這不是換成ChatGPT就能解決,而且解決掉這個距離,就代表大家都朝同質化發展,這也是值得大家思考的問題。」

至於AI會加深或縮短階級差距,劉育成表示,以前的階級大多跟社會經濟地位有關,AI時代則可能會稍微改變。「我們知道ChatGPT只要調整參數,就可以決定它怎麼回答問題,如果全世界都使用它,那麼掌握這個技術,就可能形成新的階級。」

劉育成表示,不平等一直存在不同族群之中,例如外送員在這個系統下,是比較弱勢的一方,某種程度對技術、平台本身無能為力,只能回到他現實世界的主體性,透過抗爭、罷工,去對抗演算法帶來的剝削或不公。

「社會學喜歡觀察社會不平等問題,怎樣縮短階級的差距,我覺得可以期待。我們常講科學問題不能只留給科學家,技術問題不能只留給工程師,每個學科專業都是一副眼鏡,看到的也各有不同。解決社會問題一定需要跨領域的夥伴,一起用新的方式來解決不平等。」劉育成說。

➤怎麼訓練AI的價值觀,符合社會道德?

訓練大型語言模型,不可或缺的是需要非常大量的資料,但台灣往往最困難的正是資料集太少,且不小心用了某些資料就會被炎上。網路對此也有些討論,例如Meta(FB)留言或論壇上的文章,有拒絕被用來訓練的權利嗎?吳昱宏表示:「目前台灣法規還沒有明確定義,所以如果不考慮版權,確實有非常多資料,但個資就會洩漏得一覽無餘。義大利曾禁用ChatGPT也是一樣的道理,因為OpenAI無法回答把義大利人的資料用來訓練是否合理。直到現在這仍是ChatGPT很想解決的問題。」

吳昱宏認為,使用者知道ChatGPT的原理與定位之後,最好能制定一個界線。「也就是它幫你做某些日常瑣事、節省你的時間,就當然沒問題。但如果面臨情緒擾動,比如人際關係或人生重大抉擇,這時讓ChatGPT幫你做決定就不太好了。」

此外使用者自己要有批判性思考能力,也要讓ChatGPT去批判性思考。他說:「AI處理文字的方式,只是把某些它覺得重要的部份search出來進行回答,所以你要有辦法發現它的錯誤並加以指正。這個模式有點像教一個未經世事的小孩,你會神奇地發現,它會跟你道歉,然後調整答案。也就是如果你想用它來達成某些目標,就要去『馴服』它,以避免濫用或誤用它給你的回覆。」

對於AI的道德問題,劉育成想到電影《雲端情人》(Her),劇中男主角對AI產生了情感依賴,感覺很像談戀愛,最後他問AI:「你是不是每天都在跟全世界不同的人對話?」換句話說,這個AI每天都跟全世界「劈腿」。

劉育成說:「我覺得沒錯啊!自從ChatGPT上網之後,它開始可以搜尋網路資料,我們也同時在訓練它,不斷在對話框裡餵它東西,像之前有人訓練它當一隻貓,它就開始喵喵喵。不管貓也好、虛擬情人也好,當你對它情感依賴,下一步就會吃醋、佔有。但我們面對的AI,是全世界的AI,只是透過一些方式讓你感覺客製化、好像為你而生。」

所以,最終問題還是要回到人的世界。人才有道德問題,才有應不應該的抉擇。「現在各國都在做AI的法規,但不管寵物機器人、人型機器人,AI越來越厲害之後,人類一定會對它情感投射,未來只會更突顯出來,成為一個需要解決的問題。」

關於價值觀,劉育成也想到一些例子。像是有人用AI代替猶太教的拉比來回答信仰上的問題,但沒多久就因為它回答了猶太教不能容忍的內容而被迫下架。還有一個程式叫機械佛,佛教不像猶太教那麼嚴厲,可是它的回答就很虛無縹緲。「我為什麼用這個來談價值觀?因為我覺得應該要後退一步問:何謂『正確的價值觀』。在台灣、歐美、伊斯蘭教社會,價值觀其實都不一樣,即便談普世價值(很抱歉,沒有這種東西),中國一樣講人權,可是跟我們的人權觀就是不一樣,你會發現不同社會文化裡,普世價值還是有不同內涵。」

劉育成認為更重要的問題是:我們有沒有機會去覺察ChatGPT呈現的價值觀是什麼?如果覺察不到,我們就會受影響。就如同溫層,大家都這樣做,即便是錯的,個人也不覺其怪。

劉育成解釋,現在很多學者在討論「演算法素養」、「批判演算法素養」(Critical Algorithmic Literacy)。會有這些詞彙出現,就是因為人們越來越無力面對這個問題。「媒體素養也一樣,我們都知道一直看某報,立場就會被影響,所以強調媒體素養,就是希望大家培養識別媒體立場、價值觀、意識形態的能力,包括它操作的手法、使用的文字。」

更何況ChatGPT還會亂講話。「我們期中考剛過,發現學生真的會用ChatGPT找答案,重點是你有沒有能力判斷它的對錯。技術不是你可以輕易插手的事,但我們強化批判性思考能力,就可以透過很多方式,讓它變成另外的樣子。」

身為技術學者,吳昱宏說,當發現ChatGPT某個價值觀不符期待時,其實也只有一種辦法,就是用非常多「政治正確」的資料,去對它進行洗腦。「這其實是很可怕的事情,但這麼醜陋粗暴的方法,卻是目前最快也最省時的方法。」

這件事也跟台灣和中國之所以要做自己的ChatGPT有點關係。他說,因為現在ChatGPT或LLaMA所收集的台灣相關資料極少,連中國資料集也大概16%而已,所以即便它用中文回答,隱藏的價值觀還是大美國思想。有學者提出,這可能是中國一直想開發自己ChatGPT的部分原因。

➤Q&A

●如果有一天AI能完全模擬人類情緒,幫人類負擔情緒勞動,那麼對以情感支持為生的職業,其勞動市場和就業結構有什麼影響?

劉育成:當然一定造成影響,它可能會取代某些職業。例如現在就有AI客服電話,只是設計得不太好,會很有禮貌地不斷鬼打牆,但欠缺解決方案。還有傳統需要情緒勞動的銀行員、超商店員,先前已有無人超商、無人銀行。但有些職業不會完全被取代,例如諮商師,因為這很困難。

未來我們面對各種很有禮貌、不帶情感的AI時,會不會期待它有情緒呢?也許負面的情緒我們不想要,正面的(例如撒嬌)還可以。所以AI還是可以扮演某個情感陪伴、支持的角色。很多長照悲劇都是因為情緒扛不住,日本不少研究結果都滿一致的,被照顧者多比較喜歡由機器人照護,因為可以不用看人臉色。

國外有滿多新創在做陪伴型照顧機器人,陪你聊天、幫助你進行更好的社交活動。高齡者不太能走來走去,未來也可能透過AR或XR,這些都是可以期待的。只是過程中,人類不再需要情緒勞動,會不會變成另一個樣子?機器人不會抱怨、不用休息、也不領薪水,它理所當然地照顧你,是不是我們想要的未來?這些大家都可以思考一下。

延伸閱讀:年度論壇 1》AI可以幫你愛/照顧一個人嗎?當機器人進入照護現場

●AI具批判性思考意味著什麼?因為人類批判性思考後,就知道未必要接受別人的安排、自己可以有不同選擇,強烈一點甚至會反抗。所以這點很令人好奇。

吳昱宏:ChatGPT做為工具,給大家的回覆都會符合社會對它的期待,並沒有自己思考的能力。因此我們才要透過各種方式幫助它學習,讓它反思自己講的對不對。這聽起來很像某種教育理論,但訓練語言模型真的會用到這個技術。

大家可以試試看,叫它標記一句話中所有跟情緒有關的字眼,它可能標出5個、錯了2個,這時你不只要告訴它哪些是錯的,還要教它那兩個跟上文怎麼呼應、所以不是情緒動詞等等,它就可以從中學到另一種思考模式,這就是我說的AI批判性思考。

●如何培養自己的思考能力,增加自己的批判演算判斷力?

劉育成:其實我們現在都在談AI時代的教育學,例如清大有一群老師就一直在發展AI協作教學,還有怎樣透過AI一起學習。就我自己的設計,當ChatGPT給你一串答案,你要質疑它,讓它去網路確認它給的答案是適當的,順便要它把參考資料給你看。培養這種素養,還是要回到人的投入。現在大家沒有考試就不想讀書,可是透過這個方式,可以讓AI跟著你一起學習。

例如你丟一個「你認為全球不平等有哪些面向」的問題給它,假設它給你5個答案,你可以針對其中一個繼續問「有沒有什麼例子」,以及核對它剛剛給的資料是否正確等等。我們都知道下指令很重要,如果不會問問題、不知道關鍵字怎麼下,得到的答案都會大同小異。

老師出題目、AI協作回答的這個方式,其實就是一個不斷思考、詰問、再閱讀資料求證的過程。既然大家喜歡玩AI,那我們就讓過程不只是我問你答跟照抄,這樣是沒辦法培養所謂素養的。

此外,顯性的訊息很容易判斷,隱性的資訊到底要怎樣更精確地讓演算法捕捉到,也是一個有必要解決的問題,我自己找了一些資料,但似乎沒有比較好的解決方案。

●大家很關心資訊戰,網軍會利用AI大量洗網路留言嗎?請問如何反制?

吳昱宏:我也是網路某些論壇的重度使用者,顯而易見的,ChatGPT出現後,可以生成非常多樣的回覆,輿論操縱者有更多資源與方式去帶動輿論,想達成這個目標確實相當簡單。但大家辨別資訊真假的能力也越來越強,像ChatGPT回覆的考卷其實滿明顯的,甚至論文裡的某些部分都很容易看出來,相信大家隨著時間推移,辨別資訊真假的能力也會越來越提升。

劉育成:民主國家談的是培養素養,非民主國家用的是暴力控制。只要把關鍵字篩選出來,就可以控制某種偏向,但大多數民主國家都不會這麼做,我們找不到正當性,不然用AI耙一耙之後就可以刪除、反制洗網路輿論了。

➤推薦讀物

劉育成:我推薦人工智慧先驅Marvin Minsky的科普書《The Emotion Machine》(情感機器),裡面完整交代了人工智慧具有情感意味著什麼,如果能夠讀英文的話,這本書還滿淺顯易懂的。做人工智慧研究的人,沒辦法避開Minsky這個人,所以他的書都很經典。第二本我推薦《Life 3.0:人工智慧時代,人類的蛻變與重生》,內容滿有前瞻性,可擴展我們對相關議題的認識。

吳昱宏:我一秒鐘就想到《人工智慧最後的祕密》。雖然身為使用技術的人,我反而比較關注大型語言模型對社會或政治的影響,比如OpenAI為什麼要開放ChatGPT,他們虧了幾千億台幣,當然不是為了賺錢,而是想解決自己的資料問題。大家玩ChatGPT會發現它常問你哪個比較好,只要按下去就變成他們的訓練資料。很多時候我們在網路的某些行為,都進入大公司的訓練資料中,甚至滑Meta只要停在一個地方久一點,也會變成它的訓練資料。

透過這些大量資料,就可以分析個人和整體人類的行為模式。ChatGPT很明顯是為了資料,像Google跟Amazon這些科技巨頭,對AI這件事都非常微妙地不讓大家知道他們在做什麼,卻又迫於某些狀況,必須很隱晦地讓大眾知道他們在開發非常強的模型。書裡就分析這些背後的盤算,還有一些是政治跟國家的影響,滿有趣的。●(原文於2023-11-21在Openbook官網首次刊載)

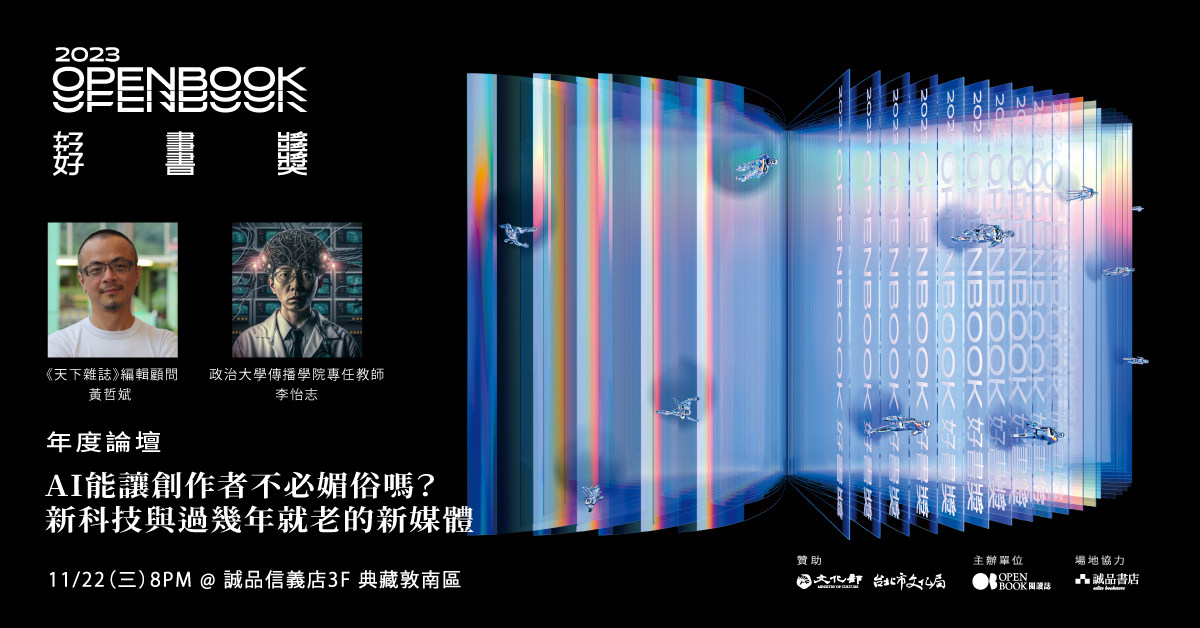

➤2023Openbook好書獎.年度論壇

▇ AI能讓創作者不必媚俗嗎?新科技與過幾年就老的新媒體

時間| 11月22日(三)20:00-21:30

地點|誠品書店信義店 敦南典藏區

主講|黃哲斌(《天下雜誌》編輯顧問)、李怡志(政治大學傳播學院專任教師)

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!

- 来自作者

- 相关推荐